|

擁有權利的同時也被賦予了重大的責任。組織可以通過遵循三個原則來減輕應用人工智慧和高級分析的風險。事實證明,人工智慧(AI)是一把雙刃劍。儘管可以說大多數是新技術,但AI刀片的兩刃都更加銳利,而且都不容易瞭解。

首先考慮積極因素。從簡化購物到增強醫療保健體驗,這些技術正開始以無數種方式改善我們的生活。他們對企業的價值也變成無法否認,正在部署AI的公司中,近80%的高級主管告訴我們,他們已經從中看到了適用價值。儘管人工智慧在商業中的廣泛使用仍處於起步階段,並且有關AI進步的步伐以及實現“通用情報”

的聖杯這些可能性仍然存在疑問,但是潛力是巨大。麥肯錫全球研究所的研究表明,到2030年,人工智慧每年可以為全球帶來產出13萬億美元的額外經濟產。

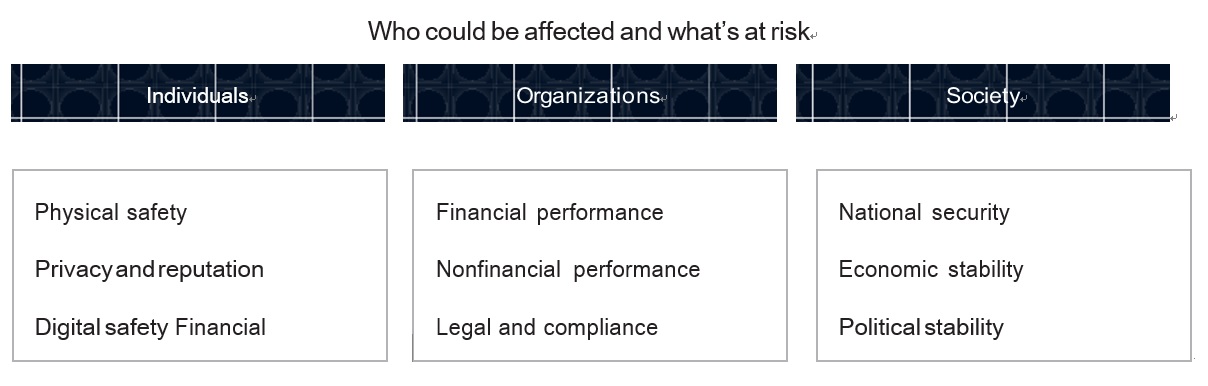

然而,即使AI能夠為消費者帶來利益和商業價值,也會帶來許多不良的後果,有時甚至是嚴重的後果。雖然在本文中專注於AI,但是這些連鎖效應以及防止或減輕它們事故的方法,同樣適用於所有的高級分析。最明顯的事件包括侵犯隱私權,歧視,意外事故和政治制度的操縱等等都已足以引起警告。更令人擔憂的是尚未能知道或尚未經歷的後果。AI可能造成災難性後果,包括如果AI醫療演算法出錯會導致人員傷亡。或者如果軍事對手對於AI系統提供虛假信息,則可能危及國家安全。對組織而言,聲譽受損也將帶來重大挑戰以及受到監管,刑事調查和公眾信任度下降而造成的收入損失。

由於人工智慧是一種相對較新的業務力量,因此很少有領導者有機會磨練自己對社會,組織和個人風險等全部範圍的直覺。或者發展其相關動力的工作知識。這些知識包括回饋數據進入AI系統,運行法算法模型以及人與機器之間的交互關係。結果,高級主管們常常忽略了潛在的危險(“例如我們不能在可能“爆炸”的事物中使用人工智慧,例如自動駕駛汽車)或高估了組織的風險緩解能力(例如我們一直在為分析工作進行很長一段時間,所以我們認為已經有了正確的控制措施,並且我們的做法與我們的行業同行一致)。領導者通常要與IT和分析組織的專家,擁有的其他人一起承擔AI風險(例如我相信我的技術團隊,他們正在盡一切可能保護我們客戶和我們的公司)。

希望避免或至少減輕意外結果的領導者,既需要建立關於AI風險的模式識別技能,又需要使得整個組織參與。以便準備好承擔與AI相關的權力和責任。識別和控制所有關鍵風險所需的工作水準大大超出了大多數組織中的現行規範。要取得真正的進步,就需要採取多樣學科的方法,涉及了高層領導和整個公司的領導者。從法律和風險到IT,到安全和分析領域的專家,以及可以確保在一線警惕的管理人員。

本文目的在首先說明一系列容易忽視的陷阱以尋求幫助。提出了一些框架,這些框架將幫助領導者識別最大的風險,並實施避免它們所需要的細微控制的廣度和深度。最後簡要介紹了當前的工作,正在通過應用這些方法來解決AI風險。

此強調的是重點是第一階後果。這些後果直接源於AI解決方案的開發,由於其無意或有意的誤用,或是為它們提供數據的數據處理不當。還有其他重要後果,其中包括因AI驅動的工作場所自動化,而在某些行業引起廣泛失業的潛力。隨著AI系統重要性的提高,還會產生第二階效應,例如技能的萎縮(例如,醫療專業人員的診斷技能)。這些後果隨著重要性的增加而將繼續受到關注,但超出了討論範圍。

了解風險及其驅動因素

當AI出問題了,而問題的根源表現出來時,常常會令人發抖。事後看來,沒人能看到這些問題這似乎是不可想像的。但是如果對位置優越的高級主管進行了一次民意測驗,以了解可能出現的下一個AI風險,那麼就不可能達成任何共識。

領導者需要更好地了解他們所承擔的風險類型,相互依存關係及其根本原因。為了幫助建立這種缺失的直覺,下面描述了五個可能導致AI風險的痛點。前三個問題(數據困難,技術問題和安全障礙)與可能被稱為AI的促成因素有關。最後兩個與AI本身至關重要的演算法和人機交互相關。顯然,我們仍處於早期階段,了解我們所承擔的風險的背後是什麼,我們還試圖將其性質和範圍歸入圖表1。

Exhibit 1

Artifical intelligence and advanced

analytics offer a host of benefits but can also give rise to a variety

of harmful, unintended consequences.

數據困難

隨著從Web,社交媒體,移動設備,感測器和物聯網等來源獲取的非結構化數據量的增加,數據的攝取,分類,鏈接和正確使用變得越來越困難。結果很容易陷入陷阱,例如無意中使用或洩露隱藏在匿名數據中的敏感信息。例如雖然可以從AI系統使用的醫療記錄的一部分中刪除患者的姓名,但是在記錄的醫生筆記部分中仍然顯示該姓名。這些注意事項對於領導人在遵守隱私權規則(例如歐盟的《通用數據保護條例》(GDPR)或《加利福尼亞消費者隱私法》(CCPA)),並保持聲譽風險方面的工作很重要。

技術上的麻煩

整個營運環境中的技術和流程問題,可能會對AI系統的性能產生負面影響。例如,一家大型金融機構在其合規軟體未能發現交易問題後就陷入了麻煩,因為數據回饋送不再包含所有客戶交易。

安全障礙

另一個新出現的問題是欺詐者可能利用公司外收集的看似不敏感的營銷,健康和財務相關數據來為人工智慧系統提供動力。如果安全預防措施不足,則可以將這些數據整合在一起以建立錯誤的標識。儘管目標公司可能在保護個人身份信息方面非常有效,卻是不為人知的幫兇,但它們仍然可能遭受消費者的強烈反對和監管的影響。

模型行為異常

人工智慧模型本身會產生問題而交付有偏見的結果時,例如如果用於訓練模型的數據中的人口代表性不足,就會發生問題。結論變得不穩定,根據在受影響的人則尚未採取的行動而做出決定。

互動問題

人機之間交互關係是另一個關鍵風險領域。其中最明顯的是自動化運輸,製造和基礎設施系統中的挑戰。如果重型設備,車輛或其他機械的操作員無法識別何時應該停止系統,或者由於操作員的注意力反應太慢而無法覆蓋系統,則可能會造成事故和傷害。這是自動駕駛汽車等應用中的明顯可能性。人為判斷也可能會在覆蓋系統結果中被證明是錯誤的。在數據分析組織中,樣式錯誤,數據管理失誤以及模型訓練數據中的錯誤判斷很容易損害公平性,隱私性,安全性和合規性。第一線人員也可能會無意中啟動問題。因為當銷售人員最擅長向某些特定人群進行銷售時,會不經意地訓練一個由AI驅動的銷售工具,而排除某些客戶群體。這些只是意想不到的後果。沒有嚴格的保護措施,心懷不滿的員工或外部敵人可能會以惡意的方式破壞演算法或扭曲使用AI的應用程序。

人工智慧風險管理:三大核心原則

除了提供前瞻性挑戰之外,以上示例和分類還有助於識別和確定風險及其根本原因的優先級。如果了解潛在的問題,誤解或根本無法識別的風險,那麼在風險發生之前,您就有更大的機會發現它們。

但是需要在整個企業範圍內進行集中的努力,才能從對風險進行分類,而且根除風險。由兩家領先銀行的經驗有助於說明所需的清晰度,廣度和細微差別。第一家是歐洲公司,一直在致力於將高級分析和AI功能應用於呼叫中心最佳化,抵押決策,關係管理和庫存管理計劃。第二個是全球領導者,尋求將機器學習模型應用於其客戶信貸決策。

這些銀行與金融服務領域的許多其他銀行一樣,已經應用了某種形式的高級分析多年,可追溯到早期在信用卡欺詐檢測和使用股票交易。它們還受到高度的監管監督,因此長期以來一直應用與透明化各種協議,和各項控制措施來減輕相關風險,包括網絡安全風險,鑑於網絡安全的明顯吸引力,它們經常處於他們的資產交給攻擊者。

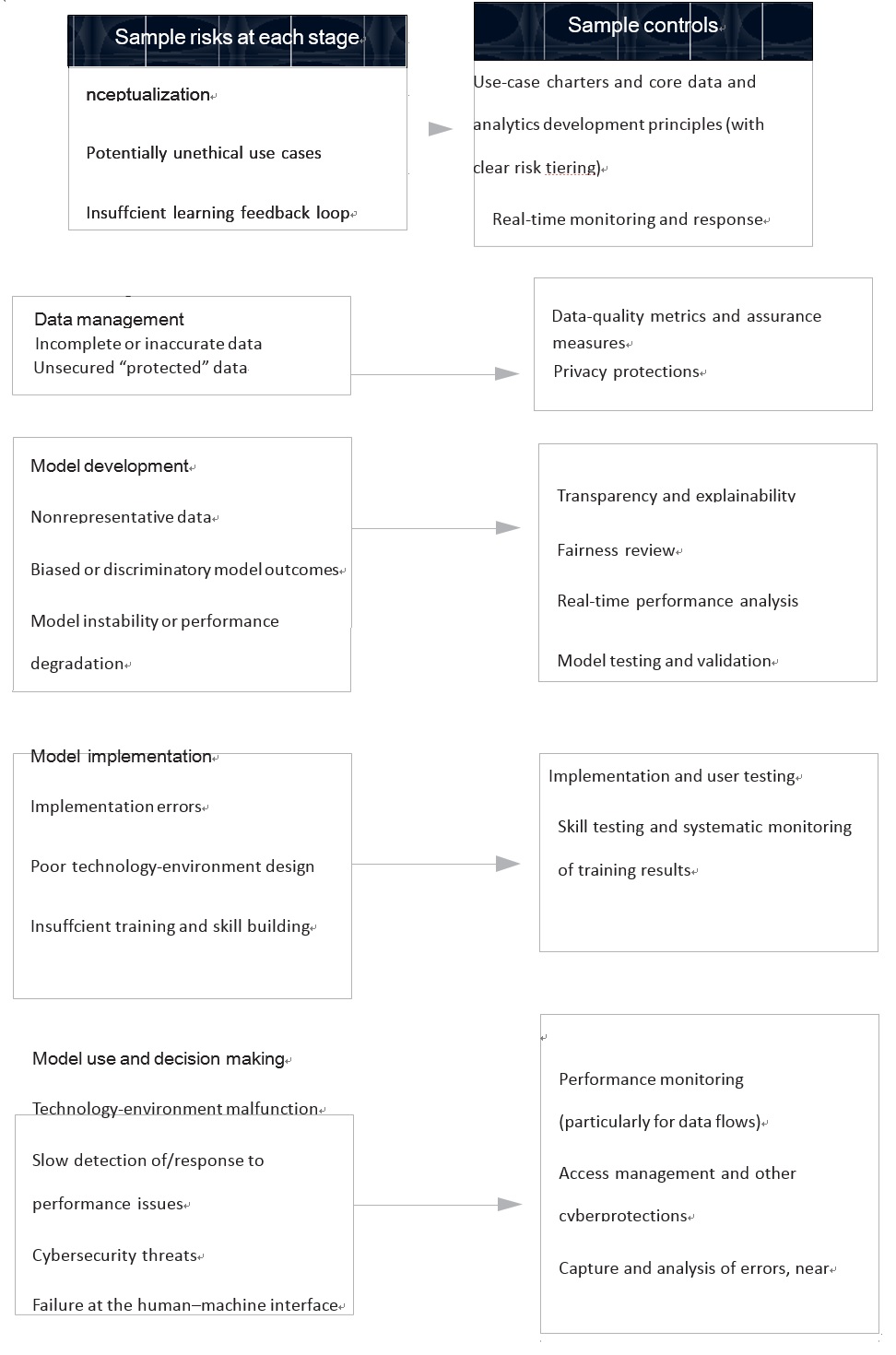

Exhibit 2

Artificial-intelligence risks can

crop up at any stage of development, but controls can help mitigate

them.

但是,這些銀行的故事僅說明了組織應考慮的特定風險控制措施的一部分。圖表2提供了一個更完整的潛在控制列表,涵蓋了從計劃到開發再到後續使用和監控的整個分析過程。我們希望將這些工具和範例放在一起,可以幫助必須面對各種問題的領導者。從避免偏見推薦引擎到消除個人身份風險,再到根據特定需求更好地定制客戶服務機器人。

明晰:

這家歐洲銀行的首席營運官使用結構化的識別方法來確定最關鍵的風險。首先召集業務,IT,安全和風險管理方面的領導人,以評估和確定其最大風險的優先級。此練習的輸入內容包括對公司現有風險的清晰了解,以及正在考慮中的AI驅動的分析工作是否加劇這些風險,以及AI支持者或AI本身可能造成的新風險。有些是顯而易見的,但有些則不是。排在榜首的意外地是向消費者提供的產品推薦不佳或偏見。這些有缺陷的建議可能會導致大量傷害和損害,包括消費者損失,強烈反對和監管罰款。

銀行領導者通過這種結構化的風險識別流程所取得的成就是,在於對最令人擔憂的情況進行了澄清,這使他們能夠對所包含的風險進行優先級排序,識別缺失的控制措施並相應地安排時間和資源。這些情況和優先級風險自然會因行業和公司而異。食品製造商可能會優先考慮受污染產品。軟體開發人員可能特別關注軟體代碼的公開。醫療保健組織可能會將重點放在患者誤診或無意對患者造成傷害等問題。讓多元化的管理人員專注於查明分層的問題,此的場景是一種激發創造力並減少狹窄的專家或眨眼的想法會錯過重大漏洞的風險的好方法。組織不必為此付出作業一切從頭開始。在過去的幾年中,風險識別已成為一種成熟的技術,可以將其直接部署在AI的文件。

廣度:建立強大的企業範圍內的控制

對阻止風險的增強思考只是一個開始。同樣重要的是應用公司範圍內的控制組件來指導AI系統的開發和使用。確保適當的監督並制定強有力的政策,程序,員人培訓和應急計劃。沒有廣泛的努力,如先前所述的風險因素將難以克服。

考慮到產品推薦不當或偏向可能帶來的風險,這家歐洲銀行開始採用一套穩健的業務原則。目的在於詳細說明如何以及在何處使用機器來做出影響客戶財務狀況的決策。經理確定了在將建議交付給客戶之前,特定人員例如客戶關係經理或信貸員,需要介入。這些工作人員將提供一個安全網,以識別客戶是否有特殊情況。例如家庭成員死亡或財務困難,這可能會使建議過時或不合適。

銀行的監督委員會還進行了差距分析,確定了銀行現有風險管理框架中需要深化。重新定義或擴展的領域。銀行全面,以一致的治理現在可以確保定義政策和程序正確。對於AI模型的特定控制,指導模型開發,職責分工和適當監督的核心原則。例如模型開發工具可確保數據科學家,在整個開發生命週期中始終記錄模型代碼,訓練數據和選擇的參數。採用了用於解釋,模型性能報告以及生產中數據和模型監視的標準庫。這種治理框架,對於內部AI開發工作以及評估和監控第三方AI工具,(例如銀行採用的SaaS欺詐模型)均具有無價的價值。

此外,銀行政策現在要求包括贊助商業務主管在內的所有利益相關者,進行場景規劃並創建一個後備計劃,以防AI模型的外在性能出現偏差。並防止數據輸入意外發生變化或突然發生變化(例如自然災害)。這些後備計劃包括在銀行的常規風險審查流程中,使董事會的風險委員會可以了解為減輕分析驅動和與AI相關的風險而採取的步驟。

在銀行減輕風險的工作中,員工培訓和意識也很突出。所有受影響的員工都會收到有關在哪裡使用AI的全面溝通。包括銀行正在採取哪些步驟來確保公平,準確的決策並保護客戶數據;以及銀行的治理框架,自動化技術和開發工具如何協同工作。此外,業務發起人,風險團隊和分析人員還需要接受有針對性的訓練,以了解他們在識別和最小化風險中的工作。例如業務發起人員被要求學習對模型行為進行解釋。他們正在使用該模型來提供有關模型背後的業務假設的反饋。同時,風險團隊已就如何更好地識別和減輕法律和法規遵從性問題進行了訓練,例如對受保護群體的潛在歧視或對GDPR的遵守。

監視AI驅動的分析是一項持續的工作,而不是一項一勞永逸的活動。因此,銀行的監督小組,包括董事會的風險委員會,需要定期審查該計劃,以掌握因監管變化,行業轉變,法律解釋(例如新興的GDPR判例法)因而可能出現的新風險,不斷變化的消費者期望以及快速變化的技術。

細微差別:

根據風險的性質加強特定的控制措施與企業範圍的控制措施一樣重要的是,它們幾乎無法以抵消每種可能的風險。經常需要另一個嚴格程度和細微差別,並且必要的控制將取決於多種因素。例如演算法的複雜性,數據要求,人機交互的性質,潛力供不良行為者利用,以及將AI整合進入業務流程的程度。有時需要從用例規範開始進行的概念控制。包括透明度要求在內的特定數據和分析控制組件以及用於回饋和監視的控制組件。例如用於檢測降級或偏差的性能分析也是如此。

我們的第二個示例為應用細微差別控制組件提供了寶貴的啟示。該機構想要了解機器學習模型如何針對特定的面向客戶的流程做出決策。在仔細考慮了透明性要求之後,該機構決定通過限制機器學習算法的類型來降低風險。禁止某些過於復雜和不透明的模型形式,使該機構能夠在舒適的環境中取得平衡。失去了一些預測能力,這付出了經濟代價。但是所使用模型的透明性使得員工對其決策具有更高的信心。較簡單的模型還使檢查數據和模型本身更加容易。以發現可能由於用戶行為或數據變量或其排名變化而產生的偏差。

如本示例所示,組織將需要混合特定於風險的控制,並且通過創建協議以確保在整個AI開發過程中到位並遵循這些協議,可以最好地實現它們。在我們的示例中,這些機構至少部分地通過其現有的風險基礎架構,實施了這些協議以及企業範圍的控制。缺乏集中風險組織的公司仍然可以使用強大的風險管理流程,來使這些AI風險管理技術發揮作用。

關於AI的組織,個人和社會所面臨的潛在風險,還有很多知識要學習。關於創新與風險之間的適當平衡;以及關於管理難以想像的控制組件的放置。到目前為止,輿論和監管反應已經相對緩和。但是,如果更多的組織陷入困境,這些可能會改變。隨著與AI相關的風險成本的上升,評估這些風險以及讓各級員工參與定義和實施控制的能力將成為競爭優勢的新來源。對許多組織而言,這是對於“客戶體驗”的新概念化,以涵蓋承諾AI驅動的成果的陷阱。另一個當務之急是就應用AI的道德規範以及限制使用AI的界限進行認真的辯論。集體行動也可能會變得越來越重要。集體行動可能會涉及有關自我監管和與監管機構接觸的行業層面的辯論。培養這些能力的組織將更有資格有效地為其客戶和社會服務;避免道德,業務,聲譽和監管方面的困境。並避免可能導致組織崩潰的潛在生存危機。

by Benjamin Cheatham, Kia

Javanmardian, and Hamid Samandari

本傑明·希瑟姆(Benjamin

Cheatham)是麥肯錫公司在費城辦公室的高級合夥人,領導麥肯錫公司在北美的QuantumBlack。

起亞Javanmardian是華盛頓特區辦公室的高級合夥人;

Hamid Samandari是紐約辦事處的高級合夥人。

作者要感謝Roger

Burkhardt,Liz

Grennan,Nicolaus

Henke,Pankaj

Kumar,Marie-Claude

Nadeau,Derek

Waldron和Olivia

White對本文的貢獻。

Copyright © 2019 McKinsey &

Company. All rights reserved.

|